~1 minute

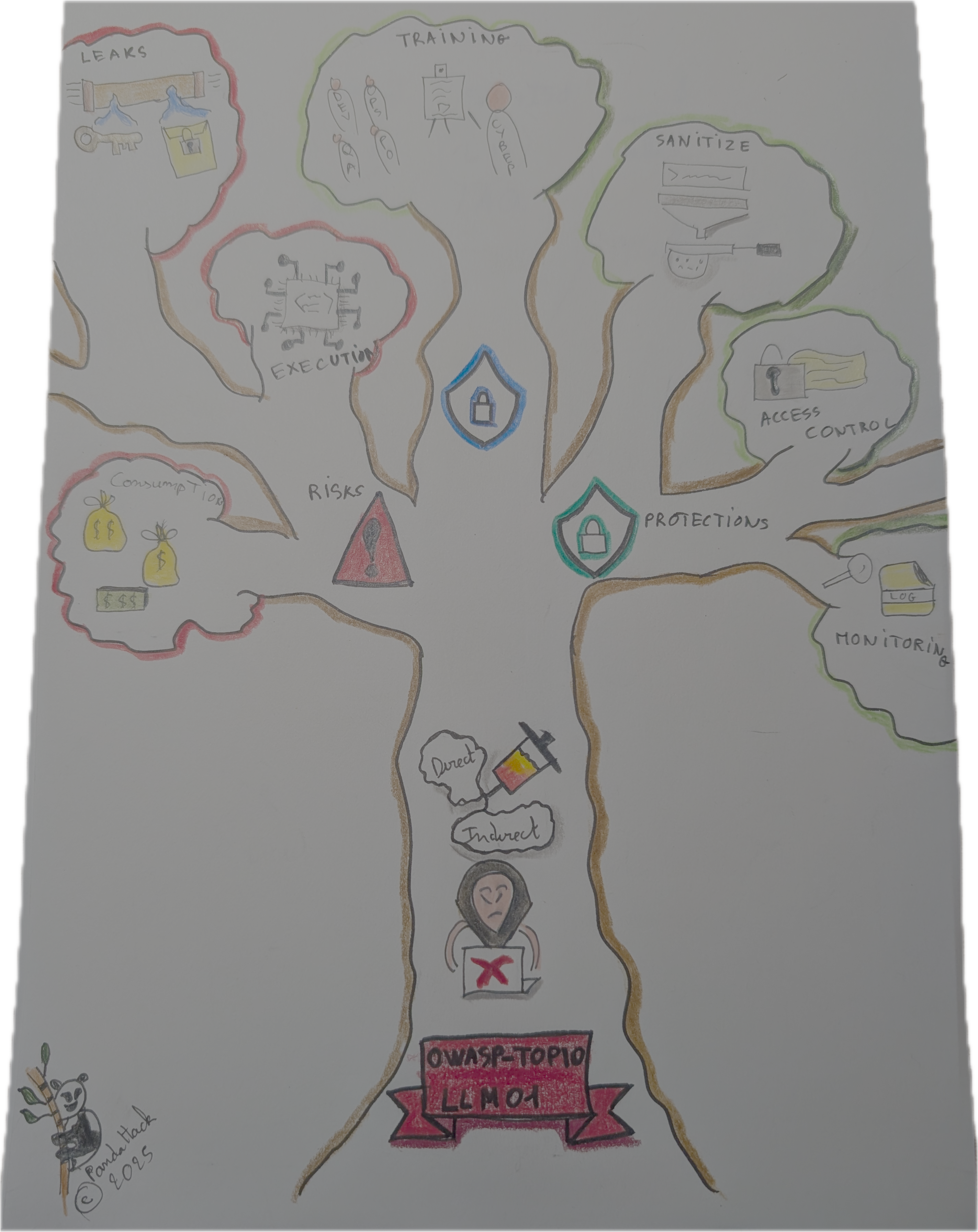

Les Large Language Models (LLM) sont de plus en plus intégrés dans diverses applications, allant des chatbots aux systèmes de recommandation. Cependant, leur utilisation croissante s’accompagne de risques de sécurité significatifs. L’un des principaux risques identifiés par l’OWASP Top 10 pour les applications LLM est l’injection de prompt.

L’injection de prompt est une vulnérabilité qui permet à un utilisateur malveillant de modifier le comportement ou la sortie d’un LLM en insérant des instructions cachées dans les entrées utilisateur. Ces instructions peuvent amener le modèle à divulguer des informations sensibles, exécuter des actions non autorisées, ou même altérer son fonctionnement de manière imprévue.

Pourquoi est-ce un Risque Majeur ? 💥

Exposition de Données Sensibles 🔓

Les LLM peuvent être exploités pour révéler des informations confidentielles. Par exemple, un attaquant pourrait formuler une requête qui incite le modèle à divulguer des données personnelles ou des secrets commerciaux.

Exécution de Commandes Non Autorisées 🛑

L’injection de prompt peut permettre l’exécution de commandes ou d’actions qui ne sont pas prévues par le système. Cela peut inclure la modification de paramètres critiques ou l’accès à des fonctionnalités restreintes.

Dégradation des Performances 📉

Des requêtes malveillantes peuvent surcharger le système, entraînant une consommation excessive de ressources et une dégradation des performances globales.

Types d’Injection de Prompt

L’injection de prompt existe principalement sous deux formes : l’injection directe et l’injection indirecte ou contextuelle. Chaque type présente des elements différents en matière de sécurité. Pour en savoir plus, consultez les articles dédiés :

En comprenant ces risques et en mettant en œuvre des mesures de sécurité appropriées , les développeurs et les organisations peuvent protéger leurs systèmes contre ces attaques.

References: